Mechanische Interpretierbarkeit für große neuronale Netzwerke

Motivation

Trotz des wachsenden Einsatzes immer größerer und leistungsfähigerer maschineller Lernmodelle in realen Anwendungen bleibt unser Verständnis davon, wie diese Modelle intern funktionieren, alarmierend begrenzt. Dieses fehlende Verständnis stellt insbesondere in sicherheitskritischen Szenarien eine Herausforderung dar, in denen das Vertrauen in die Zuverlässigkeit der Modelle entscheidend ist, und erschwert es, unvorhersehbares oder unerwünschtes Verhalten zu prognostizieren oder zu beheben.

Die mechanistische Interpretierbarkeit bietet eine vielversprechende Lösung für dieses Problem. Durch das Reverse Engineering der Algorithmen, die neuronale Netzwerke verwenden, zielt dieser Ansatz darauf ab, menschenverständliche Mechanismen hinter ihren Fähigkeiten aufzudecken. Durch die Analyse der Gewichte und Aktivierungen von neuronalen Netzwerken versucht die mechanistische Interpretierbarkeit, die Schaltkreise zu identifizieren, die für bestimmte Verhaltensweisen verantwortlich sind, und liefert so einen tieferen Einblick in die Funktionsweise dieser Modelle [Cammarata et al., 2020, Elhage et al., 2021].

Wissenschaftliche Fragestellungen

Wir untersuchen die Denkprozesse von Modellen in zwei der vielversprechendsten Bereiche: Computer Vision und Sprachmodelle.

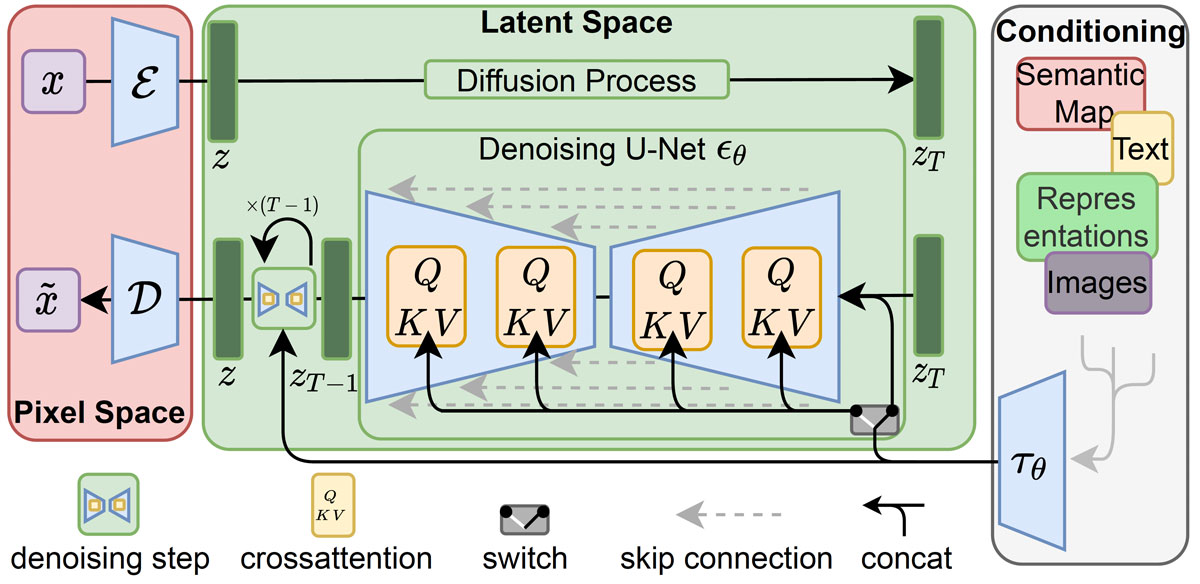

Im Bereich der Computer Vision konzentrieren wir uns auf die Untersuchung des Cross-Attention-Mechanismus, um besser zu verstehen, wie die Text-zu-Bild-Generierung funktioniert. Unser Ziel ist es, die zugrunde liegenden Prozesse dieses Mechanismus aufzudecken, insbesondere im Hinblick auf die Problematik der Halluzinationen in großen Vision-Language-Modellen (VLMs).

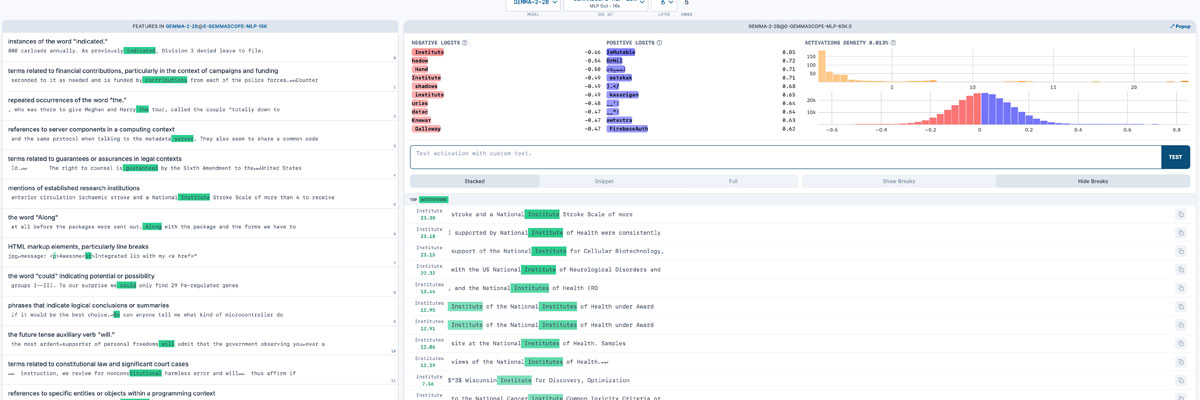

Im Bereich der Sprachmodelle möchten wir verstehen, wie große Sprachmodelle (LLMs) funktionieren, indem wir spärliche Autoencoder verwenden. Dieser Ansatz ermöglicht es uns, die zugrunde liegenden Mechanismen zu erforschen, die das Verhalten und die Denkprozesse von LLMs steuern.

Abschlussarbeiten

Neue Abschlussarbeiten werden regelmäßig im Bereich der mechanischen Interpretierbarkeit für große neuronale Netzwerke ausgeschrieben. In Übereinstimmung mit der oben genannten Projektbeschreibung gibt es mehrere Teilprobleme in diesem Projekt, die interessante Themen für Bachelor- und Masterarbeiten darstellen und in einem persönlichen Gespräch besprochen werden können.

Kooperationspartner

- Qihui Feng, M.Sc., Knowledge-based Systems Group, Informationssysteme und Datenbanken (Informatik 5), RWTH Aachen

- Yongli Mou M.Sc., Informationssysteme und Datenbanken (Informatik 5), RWTH Aachen